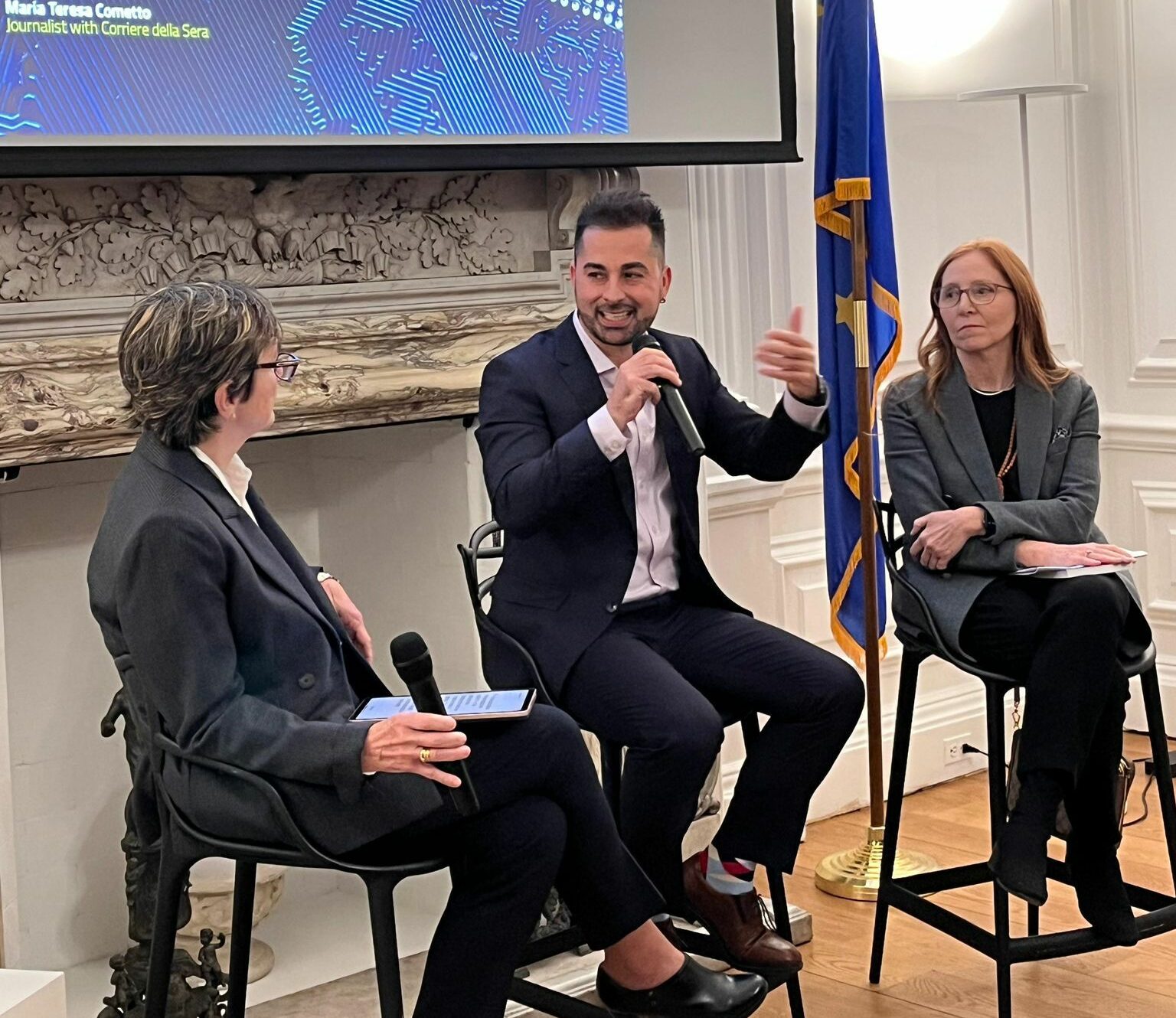

Lo scorso 23 gennaio, il Consolato italiano di New York ha ospitato un evento dedicato al tema “Intelligenza artificiale e società”, che ha visto come protagonisti Francesca Rossi ed Enrico Santus, due grandi esperti di IA impegnati rispettivamente in IBM e Bloomberg. A moderare la conversazione è stata Maria Teresa Cometto, giornalista del Corriere della Sera, che ha puntualizzato come New York sia diventata il secondo polo dell’AI negli Stati Uniti, dopo la California.

A rendere la città così attrattiva per le aziende del settore contribuisce l’ampia presenza di industrie di primaria importanza – dai servizi finanziari agli studi legali, fino alla sanità – tutte realtà che oggi richiedono soluzioni basate sull’intelligenza artificiale.

Sempre più spesso si sente parlare di IA e delle sue potenzialità in ogni ambito, ma ciò che ha reso l’evento particolarmente interessante è stata l’impronta umanistica offerta dagli ospiti, capace di focalizzare l’attenzione non solo sugli straordinari progressi tecnologici, ma anche sulle implicazioni etiche e sociali.

Francesca Rossi, che in IBM ricopre il ruolo di AI Ethics Global Leader, ha un background in informatica e intelligenza artificiale, ma si è poi dedicata all’Ethics AI. “È un ambito multidisciplinare in cui le persone con competenze tecniche si incontrano con responsabili politici e altri stakeholder dell’IA, per comprendere, identificare e mitigare problemi e rischi, e trovare soluzioni”, spiega Rossi. In IBM, il lavoro sull’AI ethics spazia da principi di alto livello su come l’azienda desidera operare e come intende che la sua tecnologia venga impiegata dai clienti, fino ad azioni concrete nella quotidianità: corsi di formazione per comprendere valori, equità, sostenibilità, trasparenza, privacy, impatto sull’occupazione e altro ancora; linee guida e strumenti software per gli sviluppatori; nonché processi interni per valutare eventuali rischi dei casi d’uso destinati ai clienti. A livello esterno, Rossi intrattiene collaborazioni con diverse realtà pubbliche e private in tutto il mondo, inclusa una proficua partnership con il Vaticano nata nel 2020 nell’ambito del documento “Rome Call for AI Ethics”, di cui IBM è stata tra i primi firmatari.

Enrico Santus, invece, in Bloomberg ricopre il ruolo di Principal Technical Strategist per la Human-AI Interaction (HAI) nell’ufficio del CTO. “La Human-AI Interaction mira a migliorare l’interfaccia tra esseri umani e IA, in modo da ottenere un’intelligenza collaborativa capace di produrre risultati superiori rispetto a quanto possa fare ciascuna parte da sola”, spiega Santus. Un esempio lampante sono i Large Language Models (LLM), la cui popolarità deriva in larga parte dalla semplicità d’uso: le persone possono interagirvi direttamente in linguaggio naturale, senza essere esperti di machine learning o ingegneri specializzati. “È un aspetto di grande interesse per la HAI, che riunisce principi provenienti da diverse discipline e include perfino attività di ‘prompt engineering’”, osserva Santus.

All’interno di Bloomberg, la HAI diventa dunque centrale per la mission aziendale: come leader nel settore finanziario globale, l’azienda ha bisogno di agevolare gli scambi tra esperti di dominio e IA durante la fase di addestramento, di migliorare l’esperienza d’uso dei clienti e di garantire la valutazione e la trasparenza delle prestazioni dei modelli, così da alimentare la fiducia degli utenti. “Si tratta di curare ogni fase – dall’addestramento al deployment, fino all’uso, alla valutazione e all’interpretazione – proprio come se stessimo progettando non solo il motore di un veicolo, ma anche il suo cruscotto: volante, pedali, cambio. In questo modo, chi guida può arrivare a destinazione in modo semplice e sicuro.”

Francesca Rossi ha pubblicato in Italia il suo secondo libro, “Intelligenza artificiale. Come funziona e dove ci porta la tecnologia che sta trasformando il mondo”, pensato per un pubblico ampio, non necessariamente esperto di tecnologia. Il testo fornisce un quadro chiaro e bilanciato dello stato attuale dell’IA: la sua storia, il modo in cui siamo arrivati fin qui, le sue applicazioni più promettenti e i rischi connessi (dalla discriminazione all’impatto sul lavoro e sull’istruzione).

Il libro affronta, inoltre, l’aspetto etico, indicando misure che gli individui, le aziende e i governi possono mettere in atto per prevenire conseguenze negative. Corredato dai contributi di esperti in diversi campi (tra cui Daniel Kahneman), offre riflessioni su come l’IA possa integrarsi con le capacità umane senza necessariamente “superarle” sotto il profilo dell’intelligenza, sottolineando invece la possibilità di una collaborazione sinergica tra uomo e macchina.

Anche Enrico Santus si orienta verso l’idea di “intelligenza collaborativa”, evidenziando che umani e macchine hanno punti di forza e debolezze diversi, il cui bilanciamento può produrre risultati molto superiori rispetto a un approccio in cui ci si affida soltanto all’uno o all’altro.

Santus sottolinea poi come “l’idea più diffusa e scorretta riguardo all’IA sia che sia davvero ‘intelligente’”: I LLM eccellono nel generare testo coerente e imitare conversazioni umane, ma spesso falliscono in compiti complessi, creando informazioni inesistenti o dando risposte incoerenti. In un recente articolo, Gary Marcus ha detto che siamo ancora lontani dalla cosiddetta AGI (Artificial General Intelligence), ma ci avviciniamo a quella che definisce “broad, shallow intelligence”: modelli che possono fare tante cose, ma senza una comprensione profonda.

I modelli di linguaggio possono ingannare e superare versioni semplificate del Test di Turing, il cosiddetto “imitation game”. Turing lo propose più o meno nel 1950: una persona doveva interagire con due agenti “nascosti” e capire quale fosse il computer e quale l’essere umano. Oggi molti potrebbero confondersi e sbagliare l’attribuzione, perché effettivamente i contenuti generati sono molto credibili. Tuttavia, se interagite molto a lungo con questi modelli, facendogli trabocchetti, scoprirete che falliscono in tanti modi, presentano svariate limitazioni. Ci sono indovinelli che li fanno crollare, inconsistenze, “allucinazioni” e così via, e questi elementi ci permettono di distinguerli ancora nettamente da un essere umano. Quindi sì, siamo ancora distanti da un’IA veramente “umana”.

Secondo Santus, è proprio per questo che la Human-AI Interaction (HAI) si rivela essenziale: per sfruttare al meglio il potenziale dei sistemi di IA e garantirne l’accuratezza, l’affidabilità e l’aderenza agli obiettivi, occorre l’intervento umano. L’IA non può ancora operare in completa autonomia, e il contributo specializzato degli esseri umani – nella supervisione, nell’interpretazione e nel giudizio – si dimostra imprescindibile.

Un aspetto particolarmente attuale concerne i pregiudizi (bias) negli algoritmi di IA, un problema che Francesca Rossi, in quanto “AI Ethics Global Leader” di IBM, affronta quotidianamente. “Il modo classico con cui si introduce il bias è tramite i dati di addestramento,” spiega infatti Rossi. “I sistemi si basano su enormi quantità di dati, che a loro volta possono contenere correlazioni non ovvie; l’IA le ‘impara’ e poi le utilizza per prendere decisioni o fare raccomandazioni, producendo discriminazioni su certi gruppi.”

Esistono già numerosi strumenti software per individuare e ridurre il bias, ma secondo Rossi “questa è la parte ‘facile’ del lavoro. La vera sfida è formare le persone che usano tali strumenti e migliorare la loro consapevolezza del bias stesso.” Come esempio, ricorda alcuni sviluppatori senior che, senza una formazione adeguata su machine learning e bias, ritenevano che, evitando di inserire variabili “protette” (come razza, genere o età) nei modelli, si potesse scongiurare ogni rischio di discriminazione. In realtà bisogna considerare anche variabili correlate, come il codice postale, che spesso riflette un’appartenenza etnica e può dunque introdurre pregiudizi indiretti. “Investire nella formazione di chi costruisce e usa l’IA è cruciale, e risulta più impegnativo che non installare un software. Inoltre, anche un sistema teoricamente privo di bias, se distribuito o applicato in maniera scorretta, può generare ingiustizie. Pensiamo a un modello creato per la popolazione di New York ma poi usato in un contesto demografico molto diverso: potrebbe emergere un bias di cui non eravamo consapevoli. È un tema molto complesso,” conclude Rossi.

Un altro fronte di discussione verte sul possibile uso scorretto di strumenti di IA come ChatGPT, soprattutto in contesti educativi. Francesca Rossi, in un’intervista rilasciata al Corriere della Sera, ha evidenziato come il pericolo più grande riguardi il settore dell’istruzione: “Gli studenti barano, svolgendo i compiti con ChatGPT, e questo è grave perché non si impegnano ad analizzare dati e informazioni, né a rielaborarli in modo critico o creativo. Il rischio è che la generazione abituata a queste tecnologie perda la capacità di criticare e innovare.”

Rossi sottolinea, infatti, che quando si chiede a uno studente di scrivere un tema, l’obiettivo non è solo produrre un buon testo, ma permettere allo studente di imparare un processo interiore: acquisire conoscenza, confrontare informazioni, valutarne la rilevanza, strutturare un ragionamento e poi esporlo in forma coerente. “Se uno strumento bypassa questo processo, lo studente non solo non impara a scrivere bene, ma nemmeno a confrontare opinioni diverse, a rispettarle, a raggiungere un compromesso. Abilità fondamentali per un adulto costruttivo. Quindi sì, vedo un serio pericolo per il futuro della società.”

Proprio su questo tema interviene Enrico Santus, che aggiunge:

“Grazie per questa domanda importante. Non c’è una risposta ‘giusta’ univoca, perché i rischi associati all’abuso dell’IA variano a seconda del contesto. L’IA, come ogni strumento, è neutrale in origine: è l’uso che ne facciamo a determinarne il potenziale positivo o negativo. Un po’ come un coltello, che può servire a preparare il cibo oppure a far del male, l’IA può migliorare la vita delle persone o finire per danneggiarle.

Tuttavia, esiste un pericolo che nel lungo termine potrebbe diventare sistemico e irreversibile: la progressiva erosione del pensiero critico a causa di un’eccessiva dipendenza dalla tecnologia e la conseguente ‘delegazione’ del pensiero stesso.

Non mi preoccupa in particolare l’uso di ChatGPT per i compiti a casa: questi strumenti faranno inevitabilmente parte del loro mondo. Quello che mi preoccupa è che si continui a educare e valutare gli studenti con criteri e metodi concepiti in un’epoca pre-AI, cioè basati su ciò che l’AI può fare al posto loro. Credo che dovremmo ripensare il sistema educativo per dare priorità al pensiero critico, alla creatività e alla capacità di risolvere problemi. È necessario costruire o riprogettare contesti formativi che favoriscano l’acquisizione di queste abilità a livello superiore.

Al di là di questo, c’è anche una responsabilità che ricade su ciascuno di noi. Con l’AI destinata a permeare ogni aspetto della nostra vita, dobbiamo prenderci il tempo di riflettere consapevolmente su come e perché la utilizziamo. La filosofa francese Simone Weil diceva che ‘l’attenzione è la forma più pura e rara di generosità’. Credo che questa affermazione sia ancora più vera oggi, in un’epoca in cui la sovrastimolazione e la scarsità di tempo ci distraggono costantemente. Coltivare attenzione verso ciò che facciamo e vogliamo è essenziale per un uso responsabile dell’IA e per restare consapevoli delle nostre azioni.”

Passando agli aspetti più pratici, la domanda sorge spontanea: come viene usata l’AI nella vita di tutti i giorni?

Enrico Santus sottolinea che “praticamente ogni strumento che usiamo oggi integra l’AI in qualche forma, che si tratti di Spotify per i suggerimenti musicali, di Netflix per le serie TV, di Uber per ottimizzare i percorsi o di Google per organizzare i risultati di ricerca: l’IA è ovunque.” Se invece si guarda agli strumenti di AI generativa – come ChatGPT – Santus li impiega per attività diverse: “Faccio riassumere articoli, generare bozze di report o post, e mi aiuto a formulare domande più mirate. Certo, devo impostare con molta cura l’input e rivedere scrupolosamente l’output, perché si tratta di un processo di collaborazione più che di automazione. Ma questi strumenti si rivelano utilissimi nell’accorciare i tempi tra una prima bozza e un prodotto finale ben rifinito.”

In definitiva, quindi, l’IA è già parte integrante della vita di tutti, in forme talvolta invisibili ma essenziali, e la prospettiva di “intelligenza collaborativa” resta la via più promettente per sfruttare appieno le potenzialità di questa tecnologia, senza rinunciare al contributo insostituibile dell’essere umano.